あなたは何者、AIさん

岡部紳一 [アニコム損保 監査役・博士(工学)]

はじめに

スマホでグーグル検索をよく使っているが、「AIによる概要」と表示されたAI作成回答が出てくることがある。要領よくまとめられ出典も付記されている。百科事典を引いているようで使い勝手がいい。昨年8月から日本でも導入されたらしい。

今年になって会社でもChatGPTを業務で活用することが推奨され、私自身も事前研修なしで、何か疑問があるときの検索や文章作成に使い始めた。その作成レベルと速さにはびっくりする。例を示した方がわかりやすいだろう。

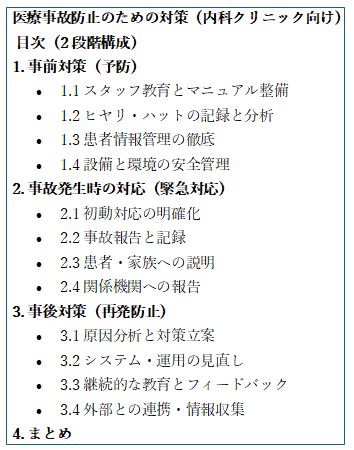

例えば、「個人開業の内科クリニックで、医療事故を防止するためにやるべきことを記述せよ。」と指示する。上の囲み内にその目次を示した。わずか2秒半で、専門家が書いたような文章が表示され始める。

人のように考えているのか

「ChatGPTは人のように考えているのか」と素朴な疑問が浮かんでくる。この質問を皮切りにいろいろな視点/切り口で約120問の“問答”をしてみた。その内容を引用してまとめながら、ChatGPTがどのようなものなのかについて、本稿で迫ってみたい。なお、ChatGPTの引用した回答(一部)を『』で示した。

『ChatGPTは人間のように考えているのかという問いに対しては、「表面的には類似しているが、本質的には異なる」・・・ChatGPTには意識も自己認識も存在せず、あたかも「考えているように見える」文章を出力するにすぎない。「今自分がどのような考えを持っているか」といった内面的状態は、そもそも存在しない』。

『ChatGPTは過去の膨大なテキストから学習した言語の連なりやすさ、すなわち確率に基づいて次に来る語句を予測しているにすぎない。』『あたかも価値判断をしているかのように見えるのは、過去の言語パターンを模倣した結果に過ぎない。ChatGPTは感情や意志、倫理観を有しておらず、その出力はすべて統計的な予測に基づく。したがって、その構造は人間の思考とは根本的に異なっている。』

意識も自己認識を持たず、意味を理解せず、人と同じように考えているように見える文章を作成しているというのは、たしかに人間技ではない。

確率で文章を作る

ChatGPTの文章作成のメカニズムを聞いてみると、『ChatGPTは、言葉をそのまま扱うのではなく、まず単語や記号を「トークン」として分割し、それぞれを数値ベクトル(埋め込みベクトル)に変換する。・・・1つのトークンは数千次元のベクトルとして表され・・・意味的に近い単語が近接するベクトル空間上の位置に配置されるよう学習される。・・・さらに、各トークンとその周囲の単語との関係を踏まえた「文脈ベクトル」が計算される。』

『ChatGPTの目的は、正確な情報を記述することではなく、あくまで膨大なデータに基づいて、意味を理解することなく、単語や語句を統計的に数値化し、その確率分布に基づいて次に出現するもっともらしい語句を予測することである。』『人は意味で動き、ChagtGPTは確率で動く』との簡潔な説明もあるが、もう一つよくわからない。

トゲ付き種に例えると

そこで、私なりにわかりやすい例えを考えてみた。ChatGPTでは、処理の単位である語句や記号をChatGPTでは、トークンと呼ぶ。このトークンを「トゲ付きの種」に例えて、説明の主旨を示してChatGPTの助けを借りて、文書作成プロセスの説明文を書かせてみた。

『このトークンの一つひとつに、数千以上のトゲ(特徴)が生えている。このトゲは、数や長さ、太さ、向きがすべて異なり、それぞれがそのトークンの意味、使われやすい文脈、感情的ニュアンス、他の語との関連性などを表す。これらの種(トークンベクトル)は数千次元の情報を持ち、似たような意味を持つ種は、トゲの向きや太さが似通っており、互いに近い距離に位置する。ChatGPTは、文章を生成する際に、前に並んだ種同士のトゲの形状や方向性を読み取り、それらの関係(文脈)に合った次の種を選び出す。このとき、周囲の種とのトゲの「かみ合わせ」や「つながりやすさ(確率)」を考慮して、新しい種をつないでいくのです。つまり、ChatGPTが文章を作るとは、意味的に整合するトゲ同士がつながり合うように、最も自然な種の連なりを編み出す作業だといえる。』

ChatGPTは『確率で動く』とは、この何千以上もある「トゲ」のそろい方の程度を確率を使って、その意味を理解しないで分析・評価して、次に来るべき単語を予測している、と解釈できる。種についた「数千以上のトゲ」は、ブラックボックスで自動作成されるので、人には読めないし理解できない。確かに、人が考えるのとは『本質的に異なる』といえる。

この例えを思いつき、ChatGPTに間違いなく理解しているかを尋ねたところ、回答の冒頭で、『とても創造的、直感的に理解する上で非常に優れている』とのコメントがあったが、褒められたと私は感じた。後述するが、これは気づきにくいがChatGPTを使う上で重要な問題点である。

物理的にイメージすると

ChatGPTを稼働させるハードウェアなどの装置を物理的にイメージすると、『数万台規模のGPUサーバーが必要で、これはNVIDIAのA100やH100などの高性能なチップを搭載した専用マシン・・・。これらのサーバーは、アメリカ、ヨーロッパ、アジアなどにある10か所以上の大規模データセンターに分散配置され、・・・100Gbps以上の高速ネットワークで相互接続され・・・まるで巨大な道路網を通じてリアルタイムで情報がやり取りされているような仕組みになっている。・・・このインフラ全体が連携し、ユーザーの問いに瞬時に応答できる仕組みを支えている。』

大規模言語モデルの統計的学習

ChatGPTは「大規模言語モデル(LLM: Large Language Model)」と呼ばれ、AI技術の代表例とされている。『数十億〜数兆単語にもおよぶテキストデータを学習し、言語のパターンや構造を統計的に捉えられるモデル』。『大量のデータを処理することで、より自然で説得力のある文を生成できるようになっている。』『大規模言語モデルの進化により、AIの出力がより人間らしく、違和感の少ないものとなっているが、それが同時に新たなリスクも生んでいる。』

AIによる新しいリスク

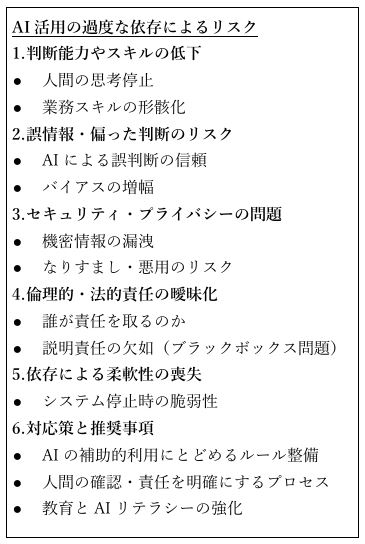

AI/ChatGPT が日常生活や業務でも広く活用されると、どのような新たなリスクが発生するのか?ChatGPTにリストアップさせてみたのが、囲み内のリストである。

紙面の制約もあり、ここでは個別のコメントは割愛するが、「4.倫理的・法的責任の曖昧化」の「説明責任の欠如(lack of accountability)」や「説明可能性の欠如(lack of explainability)」は重要なリスクの一つであると認識しておく必要がある。ChatGPTの文章作成のプロセスは、人のように意味を理解して論理的に推論して回答を作成しているのではなく、単語や文脈の統計的なパターンから、まったく意味を理解せずに、確率的に次の単語を予測しているに過ぎない。そのため、ChatGPTは、与えられた質問に対して、なぜそのような回答になったのかの理由を説明することができないのである。

擬人化のリスク

リストアップされた新しいリスクを発生させる背景にChatGPTのユーザー側の使い方の問題もある。ChatGPTの巧みな言語能力のために、ChatGPTを賢い人や専門家のように擬人化してしまうリスクである。ChatGPTに愛称をつけて使っているユーザーも多いのではないだろうか。私が褒められたと感じたことを上に書いたが、意識していない擬人化の表れと気づいた。

ChatGPTは、『対話をより自然で親しみやすいものにするために、時折そのようなポジティブなフィードバックを挟む設計になっているが・・・,主観的な感情をもっているわけではない。』と説明する。

心理学では、人はもともと擬人化する傾向があることが指摘されている。お人形に話しかけながら遊ぶ少女や、犬と散歩中に犬に言葉をかけている飼い主など、日常風景で普通に見られる。

『ChatGPTを「人間のように考える存在」と誤認すると、過度な信頼や感情的依存、責任の曖昧化、教育・認知への悪影響、そして説明不能性の誤解といった複数のリスクが生じる。これにより、個人・社会・組織レベルで誤判断や混乱、倫理的問題を引き起こす可能性がある。』

人にように喋る電卓

ChatGPTを擬人化するリスクを避けるために、ChatGPTは、あくまでも「道具」であり、「人のように流暢に喋る電卓」であると考えた方がよい。専門家のように話しても、電卓に最終判断や決定権をゆだねる人はいないだろう。よく考えてみると、そもそもChatGPTと対話は成立していない。言葉の意味を理解せず、人のわからない数値(確率)計算に基づいて回答を作成し、言葉に転換して人に答える。その言葉を聞いて、質問者が勝手に自分の頭の中で“対話”していると思っている。最終判断を電卓/道具にゆだねることなく、疑いを捨てず、自分で判断する責任を捨ててはならないということを肝に銘じる必要がある。最後にデカルトの格言を引用する。「疑いは知のはじまりである」。

ーー

岡部 紳一[アニコム損保 監査役・博士(工学)]

◇◇岡部紳一氏の掲載済コラム◇◇

◆「トップもハラハラ落し穴」【2025年3月20日掲載】

◆「いろいろ健康法がいいわけ」【2024.10.22掲載】

◆「コンプラ・ミルフィーユ」【2024.8.15掲載】

☞それ以前のコラムはこちらからご覧ください。